Data Lake Core Components: องค์ประกอบสำคัญของ Data Lake เพื่อการจัดเก็บและวิเคราะห์ข้อมูล

เมื่อองค์กรสร้างและรวบรวมข้อมูลจำนวนมหาศาลในแต่ละวัน การจัดเก็บและบริหารข้อมูลอย่างมีประสิทธิภาพจึงเป็นสิ่งสำคัญ Data Lake เป็นโซลูชันที่ช่วยจัดเก็บข้อมูลในรูปแบบที่หลากหลายโดยไม่ต้องมีโครงสร้างที่กำหนดล่วงหน้า อย่างไรก็ตาม เพื่อให้การจัดเก็บข้อมูลเป็นไปอย่างมีประสิทธิภาพ จำเป็นต้องเข้าใจ Data Lake core components ซึ่งเป็นรากฐานสำคัญของการจัดการข้อมูลในระดับองค์กร

Data Lake คืออะไร?

Data Lake เป็นที่เก็บข้อมูลขนาดใหญ่ที่รองรับข้อมูลในทุกรูปแบบ ไม่ว่าจะเป็น ข้อมูลที่มีโครงสร้าง (Structured Data), กึ่งโครงสร้าง (Semi-Structured Data), และไม่มีโครงสร้าง (Unstructured Data) โดยที่ข้อมูลสามารถเก็บอยู่ในรูปแบบดิบ (Raw Data) จนกว่าจะถูกนำไปประมวลผล

Data Lake มีความยืดหยุ่นสูงและเหมาะสำหรับการใช้งานด้าน Big Data Analytics, Machine Learning และ Business Intelligence อย่างไรก็ตาม การทำงานอย่างมีประสิทธิภาพของระบบนี้ขึ้นอยู่กับองค์ประกอบหลัก ซึ่งช่วยควบคุมกระบวนการนำเข้า จัดเก็บ ประมวลผล และรักษาความปลอดภัยของข้อมูล

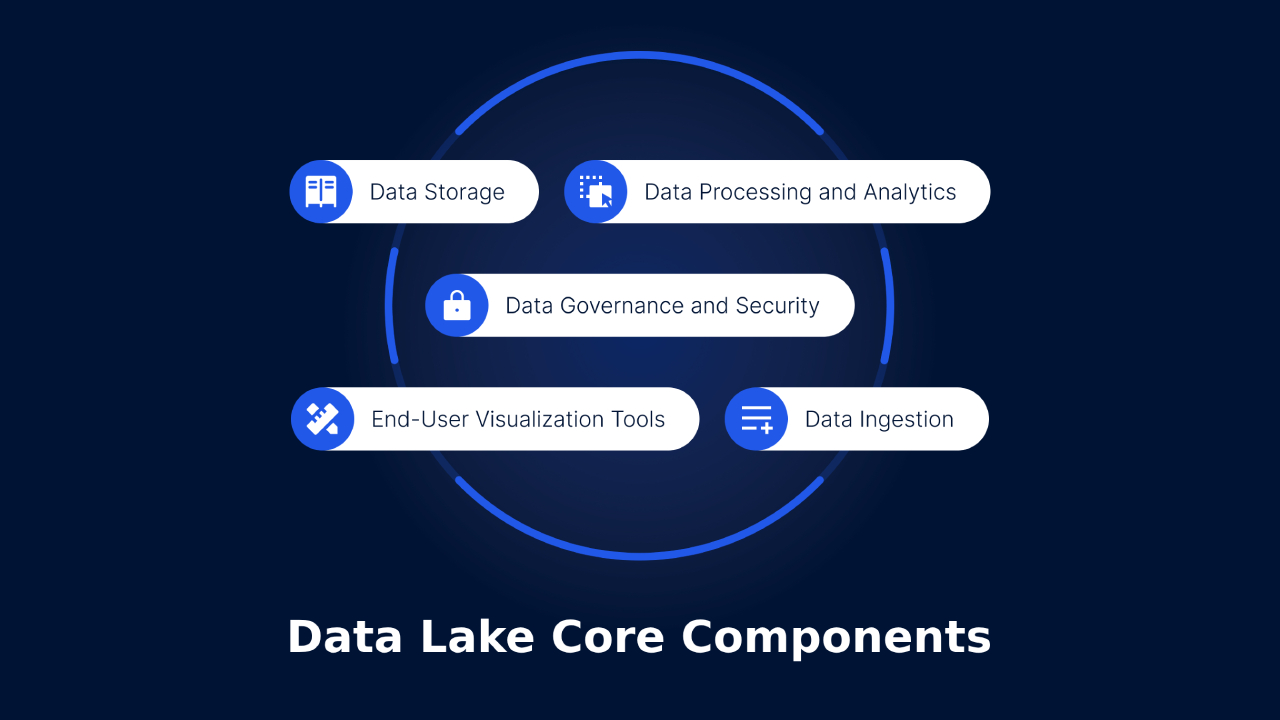

Data Lake core components

Data Lake ประกอบด้วยองค์ประกอบสำคัญหลายส่วนที่ทำงานร่วมกันเพื่อสร้างโครงสร้างที่เสถียรและสามารถขยายขนาดได้

- Data Ingestion Layer

ชั้นนำเข้าข้อมูลมีหน้าที่รวบรวมและนำข้อมูลเข้าสู่ Data Lake จากแหล่งข้อมูลต่าง ๆ ได้แก่:

- ฐานข้อมูลเชิงสัมพันธ์ (RDBMS) – เช่น SQL Server, MySQL, PostgreSQL

- ข้อมูลสตรีมมิ่งแบบเรียลไทม์ – เช่น IoT Sensors, Social Media Feeds, Web Logs

- ไฟล์ข้อมูลและเอกสาร – เช่น CSV, JSON, XML, PDF

- API และบริการคลาวด์ภายนอก – เช่น Salesforce, Google Analytics, AWS Kinesis

แนวทางปฏิบัติที่ดีที่สุด:

ใช้ ETL (Extract, Transform, Load) หรือ ELT (Extract, Load, Transform) เพื่อปรับปรุงความเร็วและคุณภาพของการนำเข้าข้อมูล

- Storage Layer

ชั้นนี้เป็นรากฐานสำคัญของโครงสร้างการจัดเก็บข้อมูล ทำหน้าที่เป็นพื้นที่จัดเก็บข้อมูลขนาดใหญ่ รองรับการขยายตัวและการเข้าถึงข้อมูลในปริมาณมาก

ประเภทของพื้นที่จัดเก็บข้อมูล:

- Cloud Storage: Azure Data Lake Storage (ADLS), AWS S3, Google Cloud Storage

- On-Premises Storage: HDFS (Hadoop Distributed File System), MinIO, Ceph

แนวทางปฏิบัติที่ดีที่สุด:

- ใช้ Data Partitioning เพื่อลดภาระในการสืบค้นข้อมูล

- ใช้ Compression Techniques เพื่อเพิ่มประสิทธิภาพการจัดเก็บข้อมูล

- Metadata and Catalog Layer

ชั้นเมตาดาต้าและแค็ตตาล็อกข้อมูลช่วยให้สามารถค้นหาและจัดการข้อมูลได้อย่างเป็นระบบ โดยข้อมูลที่ไม่มีการจัดระเบียบอาจนำไปสู่ปัญหาในการค้นคืนและวิเคราะห์

องค์ประกอบสำคัญของ Metadata Management:

- Data Catalogs: AWS Glue, Apache Hive, Azure Data Catalog

- Schema Enforcement: รองรับ Schema-on-Read และ Schema-on-Write

- Data Lineage Tracking: ช่วยให้สามารถติดตามแหล่งที่มาและการเปลี่ยนแปลงของข้อมูล

แนวทางปฏิบัติที่ดีที่สุด:

- ใช้ Automated Metadata Tagging เพื่อเพิ่มความสามารถในการค้นหาข้อมูล

- ใช้ Machine Learning-based Data Classification เพื่อกำหนดหมวดหมู่ข้อมูลอัตโนมัติ

- ชั้นการประมวลผลและวิเคราะห์ข้อมูล (Processing and Analytics Layer)

เมื่อข้อมูลถูกนำเข้าและจัดเก็บแล้ว จำเป็นต้องมีการประมวลผลและวิเคราะห์เพื่อให้ได้ข้อมูลเชิงลึก ชั้นการประมวลผล ช่วยให้สามารถดำเนินการ ประมวลผลแบบกลุ่ม (Batch Processing), การวิเคราะห์ข้อมูลแบบเรียลไทม์ (Real-Time Analytics), และการประยุกต์ใช้ Machine Learning ได้อย่างมีประสิทธิภาพ

เครื่องมือที่ใช้สำหรับการประมวลผลข้อมูล:

- การประมวลผลแบบกลุ่ม: Apache Spark, Hadoop MapReduce, Azure Data Factory

- การสตรีมข้อมูลแบบเรียลไทม์: Apache Kafka, AWS Kinesis, Google Dataflow

- Machine Learning และ AI: TensorFlow, Databricks, Microsoft Synapse Analytics

แนวทางปฏิบัติที่ดีที่สุด:

เลือกใช้ Framework การประมวลผลที่เหมาะสมกับปริมาณงาน โดยใช้ Batch Processing สำหรับการวิเคราะห์ข้อมูลในอดีต และ Real-Time Processing สำหรับการประมวลผลข้อมูลที่เกิดขึ้นแบบทันที

- ชั้นการกำกับดูแลและความปลอดภัยของข้อมูล (Data Governance and Security Layer)

ความปลอดภัยและการกำกับดูแล มีความสำคัญต่อการรักษาความถูกต้องของข้อมูล ความเป็นส่วนตัว และการปฏิบัติตามข้อกำหนดด้านกฎหมาย ชั้นการกำกับดูแลข้อมูล ช่วยควบคุมคุณภาพของข้อมูล การเข้าถึง และการบังคับใช้นโยบายด้านความปลอดภัย

ฟีเจอร์สำคัญด้านความปลอดภัย:

- Role-Based Access Control (RBAC): กำหนดสิทธิ์การเข้าถึงข้อมูลตามบทบาทของผู้ใช้

- การเข้ารหัสข้อมูล: ใช้เทคโนโลยีการเข้ารหัสทั้งขณะจัดเก็บและขณะส่งผ่านข้อมูล เช่น SSL/TLS, AES-256

- การปฏิบัติตามข้อกำหนดและการตรวจสอบ: ปฏิบัติตามมาตรฐานด้านความปลอดภัยของข้อมูล เช่น GDPR, HIPAA, SOC 2

แนวทางปฏิบัติที่ดีที่สุด:

ใช้ เทคนิคการปกปิดข้อมูล (Data Masking) และการทำให้ข้อมูลไม่ระบุตัวตน (Anonymization) เพื่อป้องกันการเข้าถึงข้อมูลสำคัญโดยไม่ได้รับอนุญาต

แนวทางปฏิบัติที่ดีที่สุดในการสร้าง Data Lake ที่ขยายขนาดได้

เพื่อให้ Data Lake มีประสิทธิภาพสูงสุด ควรดำเนินการตามแนวทางดังต่อไปนี้:

- เพิ่มประสิทธิภาพต้นทุนการจัดเก็บข้อมูล: ใช้โซลูชันการจัดเก็บข้อมูลแบบแบ่งชั้น (Hot, Warm, Cold Storage) เพื่อลดค่าใช้จ่าย

- รักษาคุณภาพของข้อมูล: ใช้มาตรการตรวจสอบความถูกต้องของข้อมูล และกำจัดข้อมูลซ้ำซ้อนก่อนนำเข้า

- ใช้ระบบตรวจสอบและระบบอัตโนมัติ: ใช้เครื่องมือที่ขับเคลื่อนด้วย AI เพื่อตรวจจับความผิดปกติและทำให้เวิร์กโฟลว์เป็นอัตโนมัติ

- ให้ผู้ใช้สามารถเข้าถึงข้อมูลได้ง่าย: ใช้เครื่องมือจัดระเบียบข้อมูลและการแสดงผล เช่น Power BI, Tableau

- ดำเนินการตรวจสอบความปลอดภัยอย่างสม่ำเสมอ: ทำการตรวจสอบช่องโหว่ด้านความปลอดภัยและบังคับใช้นโยบายการรักษาความปลอดภัยของข้อมูล

ตัวอย่างการใช้งานจริงของ Data Lake

ภาคค้าปลีกและอีคอมเมิร์ซ

ธุรกิจค้าปลีกใช้ Data Lake เพื่อวิเคราะห์พฤติกรรมลูกค้า ติดตามแนวโน้มสินค้าคงคลัง และเพิ่มประสิทธิภาพแคมเปญการตลาด

ภาคการเงินและบริการฟินเทค

ธนาคารและบริษัทฟินเทคใช้ Data Lake ในการตรวจจับการฉ้อโกง การบริหารความเสี่ยง และการวิเคราะห์กลุ่มลูกค้า

ภาคการแพทย์และวิทยาศาสตร์ชีวภาพ

โรงพยาบาลและศูนย์วิจัยทางการแพทย์จัดเก็บข้อมูลเวชระเบียนอิเล็กทรอนิกส์ (EHR) ข้อมูลจีโนม และภาพถ่ายทางการแพทย์เพื่อวิเคราะห์แนวโน้มด้านสุขภาพ

ภาคอุตสาหกรรมและ IoT

Data Lake ช่วยให้บริษัทผู้ผลิตสามารถทำการบำรุงรักษาเชิงพยากรณ์ วิเคราะห์ข้อมูลจากเซ็นเซอร์ และตรวจสอบการดำเนินงานแบบเรียลไทม์

สรุป

การทำความเข้าใจ Data Lake Core Components เป็นสิ่งสำคัญในการออกแบบระบบการจัดการข้อมูลที่มีประสิทธิภาพ ขยายขนาดได้ และปลอดภัย ตั้งแต่การนำเข้าข้อมูล การประมวลผล การกำกับดูแล และความปลอดภัย ทุกองค์ประกอบมีบทบาทสำคัญในการสร้างระบบที่รองรับการดำเนินงานขององค์กรได้อย่างราบรื่น

ด้วยแนวทางปฏิบัติที่ดีที่สุดและการใช้เทคโนโลยีที่ทันสมัย องค์กรสามารถปลดล็อกศักยภาพของ Data Lake เพื่อ วิเคราะห์ข้อมูลขั้นสูง ปัญญาประดิษฐ์ และการตัดสินใจแบบเรียลไทม์ ได้อย่างมีประสิทธิภาพ

เรียนรู้เพิ่มเติมเกี่ยวกับแนวทางการจัดการข้อมูลสมัยใหม่ได้ที่ Microsoft Learn – Data Architecture.

สำรวจเครื่องมือดิจิทัลของเรา

หากคุณสนใจในการนำระบบจัดการความรู้มาใช้ในองค์กรของคุณ ติดต่อ SeedKM เพื่อขอข้อมูลเพิ่มเติมเกี่ยวกับระบบจัดการความรู้ภายในองค์กร หรือสำรวจผลิตภัณฑ์อื่นๆ เช่น Jarviz สำหรับการบันทึกเวลาทำงานออนไลน์, OPTIMISTIC สำหรับการจัดการบุคลากร HRM-Payroll, Veracity สำหรับการเซ็นเอกสารดิจิทัล, และ CloudAccount สำหรับการบัญชีออนไลน์

อ่านบทความเพิ่มเติมเกี่ยวกับระบบจัดการความรู้และเครื่องมือการจัดการอื่นๆ ได้ที่ Fusionsol Blog, IP Phone Blog, Chat Framework Blog, และ OpenAI Blog.