เปิดตัว gpt-oss-safeguard: แบบจำลองเหตุผลด้านความปลอดภัยแบบเปิดสำหรับนักพัฒนา

OpenAI ได้เปิดตัว gpt-oss-safeguard ซึ่งเป็นนวัตกรรมใหม่ในตระกูลแบบจำลองเหตุผลแบบเปิด (open-weight reasoning models) ที่ออกแบบมาสำหรับงานจำแนกด้านความปลอดภัยโดยเฉพาะ ถือเป็นการพัฒนาอย่างก้าวกระโดดในการช่วยให้นักพัฒนาสามารถสร้าง ทดสอบ และปรับใช้ระบบความปลอดภัยเฉพาะทางได้อย่างยืดหยุ่น แบบจำลองนี้มีให้เลือก 2 ขนาด ได้แก่ 120B และ 20B ซึ่งเป็นเวอร์ชันที่ปรับแต่งมาจาก gpt-oss ดั้งเดิม และเผยแพร่ภายใต้สัญญาอนุญาตแบบ Apache 2.0 ทำให้สามารถใช้งานและปรับแก้ได้อย่างเสรี

ทั้งสองโมเดลสามารถดาวน์โหลดได้แล้ววันนี้จาก Hugging Face เพื่อให้นักวิจัยและนักพัฒนาสามารถเข้าถึงเครื่องมือเหตุผลด้านความปลอดภัยขั้นสูงที่ปรับให้เข้ากับนโยบายและมาตรฐานของแต่ละองค์กรได้

มุมมองใหม่ของการใช้เหตุผลด้านความปลอดภัย

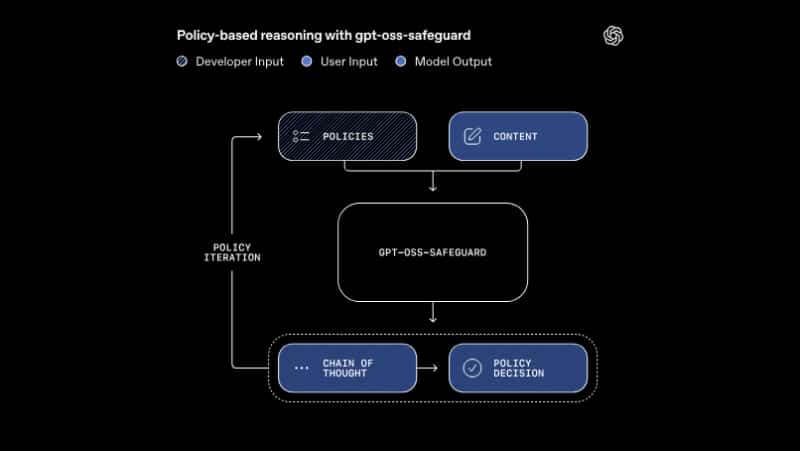

ต่างจากตัวจำแนก (classifier) แบบดั้งเดิมที่ถูกฝึกด้วยข้อมูลตายตัว gpt-oss-safeguard ใช้การให้เหตุผลแบบเรียลไทม์ตามนโยบายที่นักพัฒนากำหนด ซึ่งหมายความว่าโมเดลสามารถจำแนกข้อความ การตอบกลับ หรือบทสนทนาตามนโยบายเฉพาะของนักพัฒนาได้แบบไดนามิก มอบความยืดหยุ่นและความโปร่งใสในระดับสูง

ในขั้นตอนการอนุมาน (inference) โมเดลจะรับข้อมูลสองส่วนคือ:

- นโยบายด้านความปลอดภัย (ที่นักพัฒนากำหนด)

- เนื้อหาที่ต้องการประเมิน

จากนั้นโมเดลจะสร้างผลลัพธ์พร้อม “เหตุผลของการตัดสินใจ” (reasoning chain) ที่สามารถตรวจสอบและปรับปรุงได้ ซึ่งช่วยให้นักพัฒนาเข้าใจและเชื่อมั่นในกระบวนการตัดสินใจของโมเดลมากยิ่งขึ้น

แนวทางนี้ช่วยให้องค์กรสามารถปรับหรือขยายขอบเขตของนโยบายความปลอดภัยได้ทันทีโดยไม่ต้องฝึกโมเดลจำแนกใหม่ทั้งหมด เพิ่มความยืดหยุ่นในการตอบสนองต่อสถานการณ์ที่เปลี่ยนแปลงอย่างรวดเร็ว

วิธีที่ gpt-oss-safeguard สนับสนุนนโยบายความปลอดภัยเฉพาะทาง

ด้วย gpt-oss-safeguard นักพัฒนาสามารถออกแบบระบบความปลอดภัยให้เหมาะสมกับแพลตฟอร์มของตน เช่น

- ฟอรั่มเกมสามารถจำแนกการพูดคุยเกี่ยวกับการโกงหรือพฤติกรรมไม่เหมาะสม

- แพลตฟอร์มอีคอมเมิร์ซสามารถตรวจจับรีวิวปลอมหรือเนื้อหาชวนเข้าใจผิด

- โซเชียลมีเดียสามารถใช้กฎการกลั่นกรองเฉพาะชุมชนที่ปรับเปลี่ยนได้ตามเวลา

กลไกเหตุผลนี้มีประโยชน์เป็นพิเศษในกรณีที่:

- พฤติกรรมที่เป็นอันตรายมีการเปลี่ยนแปลงอย่างรวดเร็ว

- หัวข้อมีความซับซ้อนเกินกว่าที่โมเดลขนาดเล็กจะเข้าใจ

- ไม่มีข้อมูลที่มีการระบุฉลากเพียงพอสำหรับการฝึก

- ต้องการคำตัดสินที่โปร่งใสและสามารถอธิบายได้มากกว่าความเร็วในการประมวลผล

การใช้เหตุผลด้านความปลอดภัยภายในของ OpenAI

ระบบภายในของ OpenAI ใช้วิธีเดียวกันนี้ที่เรียกว่า Safety Reasoner ซึ่งทำงานอยู่เบื้องหลังของโมเดลอย่าง GPT-5, ChatGPT Agent และ Sora 2 วิธีนี้เรียกว่า deliberative alignment — เป็นกระบวนการที่ให้โมเดล AI ใช้เหตุผลโดยตรงเกี่ยวกับนโยบายความปลอดภัยแทนที่จะพึ่งเพียงตัวอย่างที่เรียนรู้มา

Safety Reasoner จะนำกฎด้านความปลอดภัยมาใช้แบบเรียลไทม์ โดยใช้ทรัพยากรคอมพิวต์สูงสุดถึง 16% ของระบบทั้งหมด เพื่อให้สามารถปรับขอบเขตความปลอดภัยได้ทันต่อความเสี่ยงที่เปลี่ยนไป ช่วยเสริมการป้องกันในระดับลึกของแพลตฟอร์ม

สำหรับโมเดลภาพและวิดีโอ เช่น Sora 2 ระบบ Safety Reasoner จะทำการตรวจสอบความปลอดภัยในแต่ละขั้นตอนแบบเรียลไทม์ เพื่อระบุและบล็อกผลลัพธ์ที่ไม่ปลอดภัยก่อนถึงผู้ใช้

ประสิทธิภาพและการประเมินผล

OpenAI ได้ประเมิน gpt-oss-safeguard ด้วยชุดข้อมูลทั้งภายในและสาธารณะ เช่น ToxicChat และ Moderation dataset ปี 2022

ผลการทดสอบแสดงว่า:

- gpt-oss-safeguard มีความแม่นยำในการให้เหตุผลตามนโยบายหลายแบบเหนือกว่า gpt-5-thinking และ gpt-oss รุ่นก่อนหน้า

- เมื่อทดสอบกับข้อมูลการกลั่นกรองและความเป็นพิษ (toxicity) โมเดลแสดงให้เห็นถึงความสามารถในการตีความและการปรับตัวที่ดีกว่าตัวจำแนกแบบดั้งเดิมในสถานการณ์ที่ซับซ้อน

- แม้เวอร์ชัน 20B จะมีขนาดเล็กกว่า แต่ยังคงมีประสิทธิภาพสูงในกรณีใช้งานด้านการกลั่นกรองเนื้อหาในโลกจริง

ข้อจำกัดและการแลกเปลี่ยน

แม้ว่า gpt-oss-safeguard จะมีความยืดหยุ่นและโปร่งใส แต่ก็มีข้อจำกัดอยู่สองประการคือ:

- เพดานประสิทธิภาพ (Performance ceiling): ตัวจำแนกเฉพาะทางที่ฝึกด้วยข้อมูลขนาดใหญ่และมีคุณภาพสูงอาจยังคงแม่นยำกว่าในบางโดเมนที่ซับซ้อนมาก

- ต้นทุนการประมวลผล (Compute cost): การจำแนกแบบใช้เหตุผลต้องใช้ทรัพยากรสูง ทำให้ไม่เหมาะกับระบบที่ต้องการความเร็วสูงและประมวลผลปริมาณมาก

OpenAI แก้ไขข้อจำกัดนี้ด้วยการผสานตัวจำแนกขนาดเล็กที่รวดเร็วเข้ากับ Safety Reasoner เพื่อทำการวิเคราะห์เชิงลึกเมื่อจำเป็น

ความร่วมมือกับชุมชนด้านความปลอดภัย

การเปิดตัว gpt-oss-safeguard เป็นส่วนหนึ่งของพันธกิจ OpenAI ในการสร้างความร่วมมือแบบเปิด โดยโมเดลนี้ได้รับการพัฒนาและทดสอบร่วมกับ ROOST, SafetyKit, Tomoro และ Discord เพื่อตอบสนองความต้องการของนักพัฒนาในสถานการณ์จริง

Vinay Rao (CTO ของ ROOST) กล่าวว่านี่คือโมเดลเหตุผลแบบโอเพ่นซอร์สรุ่นแรกที่มีแนวคิด “bring your own policy” ซึ่งให้องค์กรสามารถกำหนดนิยามของความเสี่ยงได้เองพร้อมคงความโปร่งใสในกระบวนการกลั่นกรอง

นอกจากนี้ ROOST ยังได้เปิดตัว ROOST Model Community (RMC) — ศูนย์กลางสำหรับนักวิจัยและนักพัฒนาในการแลกเปลี่ยนความรู้ ทดสอบระบบความปลอดภัย และปรับปรุงระบบกลั่นกรองโอเพ่นซอร์สร่วมกัน

เริ่มต้นใช้งาน gpt-oss-safeguard

นักพัฒนาสามารถเริ่มใช้งาน gpt-oss-safeguard ได้แล้ววันนี้โดยดาวน์โหลดโมเดลจาก Hugging Face ด้วยสถาปัตยกรรมแบบ reasoning-first ผู้ใช้สามารถ:

- ทดลองสร้างนโยบายความปลอดภัยแบบไดนามิก

- วิเคราะห์เหตุผลของโมเดลเพื่อปรับปรุงนโยบาย

- ผสานกลไกเหตุผลแบบเปิดเข้ากับระบบกลั่นกรองเนื้อหา

นี่ถือเป็นก้าวสำคัญของการทำให้ความปลอดภัยของ AI เป็นเรื่องที่ “เปิดกว้างและปรับแต่งได้” เพื่อให้นักพัฒนาสามารถกำหนดและควบคุมมาตรฐานความปลอดภัยของระบบตนเองได้อย่างแท้จริง

สรุป

การเปิดตัว gpt-oss-safeguard ถือเป็นก้าวสำคัญในการยกระดับความปลอดภัยของ AI แบบเปิด ด้วยการผสานพลังการให้เหตุผลและกรอบนโยบายที่ยืดหยุ่น OpenAI มอบความสามารถให้นักพัฒนาสามารถออกแบบระบบป้องกันเฉพาะทางสำหรับแพลตฟอร์มของตนเองได้ ไม่ว่าจะใช้ในการกลั่นกรองเนื้อหา ระบบ trust & safety หรือการบังคับใช้กฎชุมชน โมเดลนี้จะช่วยให้องค์กรสามารถปกป้องผู้ใช้อย่างโปร่งใส ตรวจสอบได้ และปรับตัวได้ตามโลกดิจิทัลที่เปลี่ยนแปลงอยู่ตลอดเวลา

สนใจผลิตภัณฑ์และบริการของ Microsoft หรือไม่ ส่งข้อความถึงเราที่นี่

สำรวจเครื่องมือดิจิทัลของเรา

หากคุณสนใจในการนำระบบจัดการความรู้มาใช้ในองค์กรของคุณ ติดต่อ SeedKM เพื่อขอข้อมูลเพิ่มเติมเกี่ยวกับระบบจัดการความรู้ภายในองค์กร หรือสำรวจผลิตภัณฑ์อื่นๆ เช่น Jarviz สำหรับการบันทึกเวลาทำงานออนไลน์, OPTIMISTIC สำหรับการจัดการบุคลากร HRM-Payroll, Veracity สำหรับการเซ็นเอกสารดิจิทัล, และ CloudAccount สำหรับการบัญชีออนไลน์

อ่านบทความเพิ่มเติมเกี่ยวกับระบบจัดการความรู้และเครื่องมือการจัดการอื่นๆ ได้ที่ Fusionsol Blog, IP Phone Blog, Chat Framework Blog, และ OpenAI Blog.

New Gemini Tools For Educators: Empowering Teaching with AI

ถ้าอยากติดตามข่าวเทคโนโลยีและข่าว AI ที่กำลังเป็นกระแสทุกวัน ลองเข้าไปดูที่ เว็บไซต์นี้ มีอัปเดตใหม่ๆ ให้ตามทุกวันเลย!

Fusionsol Blog in Vietnamese

Related Articles

Frequently Asked Questions (FAQ)

Microsoft Copilot คืออะไร?

Microsoft Copilot คือฟีเจอร์ผู้ช่วยอัจฉริยะที่ใช้ AI เพื่อช่วยในการทำงานภายในแอปของ Microsoft 365 เช่น Word, Excel, PowerPoint, Outlook และ Teams โดยทำหน้าที่ช่วยสรุป เขียน วิเคราะห์ และจัดการข้อมูล

Copilot ใช้งานได้กับแอปไหนบ้าง?

ปัจจุบัน Copilot รองรับ Microsoft Word, Excel, PowerPoint, Outlook, Teams, OneNote, และอื่น ๆ ในตระกูล Microsoft 365

ต้องเชื่อมต่ออินเทอร์เน็ตหรือไม่จึงจะใช้งาน Copilot ได้?

จำเป็นต้องเชื่อมต่ออินเทอร์เน็ต เนื่องจาก Copilot ทำงานร่วมกับโมเดล AI บนคลาวด์เพื่อให้ผลลัพธ์ที่แม่นยำและอัปเดตข้อมูลล่าสุด

สามารถใช้ Copilot ช่วยเขียนเอกสารหรืออีเมลได้อย่างไร?

ผู้ใช้สามารถพิมพ์คำสั่ง เช่น “สรุปรายงานในย่อหน้าเดียว” หรือ “เขียนอีเมลตอบลูกค้าอย่างเป็นทางการ” และ Copilot จะสร้างข้อความให้ตามคำสั่ง

Copilot ปลอดภัยต่อข้อมูลส่วนบุคคลหรือไม่?

ใช่ Copilot ได้รับการออกแบบโดยยึดหลักความปลอดภัยและการปกป้องความเป็นส่วนตัว โดยข้อมูลของผู้ใช้จะไม่ถูกใช้ในการฝึกโมเดล AI และมีระบบการควบคุมสิทธิ์การเข้าถึงข้อมูลอย่างเข้มงวด