GPT-5.3 Codex Spark: การเขียนโค้ดแบบเรียลไทม์ด้วยความหน่วงต่ำพิเศษ

วิวัฒนาการขั้นถัดไปของการพัฒนาซอฟต์แวร์ด้วย AI มาถึงแล้ว GPT-5.3 Codex Spark เปิดให้ใช้งานในรูปแบบ research preview โดยเป็นโมเดลแรกของ OpenAI ที่ออกแบบมาโดยเฉพาะสำหรับการทำงานร่วมกันด้านการเขียนโค้ดแบบเรียลไทม์

ในฐานะโมเดลขนาดเล็กและรวดเร็วเป็นพิเศษที่พัฒนาต่อยอดจาก GPT-5.3 Codex นั้น GPT-5.3 Codex Spark ถูกปรับแต่งให้ตอบสนองแทบจะทันที เมื่อให้บริการผ่านฮาร์ดแวร์ความหน่วงต่ำพิเศษจากความร่วมมือกับ Cerebras โมเดลสามารถสร้างผลลัพธ์ได้มากกว่า 1000 โทเคนต่อวินาที ยกระดับความลื่นไหลของการพัฒนาซอฟต์แวร์ด้วย AI ไปอีกขั้น

GPT-5.3 Codex Spark คืออะไร?

GPT-5.3 Codex Spark คือโมเดลสำหรับงานเขียนโค้ดที่เน้นความเร็วสูง ออกแบบมาเพื่อรองรับ:

- การพัฒนาแบบโต้ตอบ (Interactive development)

- การทำงานแบบปรับแก้อย่างรวดเร็ว (Rapid iteration)

- การปรับตรรกะทันที (Immediate logic refinement)

- การแก้ไขโค้ดแบบเกือบเรียลไทม์

ต่างจากโมเดลขนาดใหญ่ที่ออกแบบมาสำหรับงานอัตโนมัติระยะยาวที่กินเวลาหลายชั่วโมงหรือหลายวัน GPT-5.3 Codex Spark ถูกปรับให้เหมาะกับการทำงาน “ในขณะนั้น” นักพัฒนาสามารถปรับโครงสร้าง แก้ตรรกะ หรือปรับอินเทอร์เฟซ และเห็นผลลัพธ์ทันที

ปัจจุบันรองรับ:

- Context window ขนาด 128K

- อินพุตแบบข้อความเท่านั้น

- Rate limit แยกสำหรับช่วง research preview

- สิทธิ์เข้าถึงสำหรับผู้ใช้ ChatGPT Pro

ที่สำคัญ การใช้งานในช่วง research preview จะไม่ถูกนับรวมกับ rate limit มาตรฐาน

ออกแบบเพื่อการทำงานร่วมกันแบบเรียลไทม์

ความเร็วเป็นปัจจัยสำคัญของการพัฒนาซอฟต์แวร์ Codex Spark จึงถูกสร้างมาเพื่อการทำงานร่วมกันแบบโต้ตอบ ที่ความหน่วง (latency) สำคัญพอ ๆ กับความฉลาดของโมเดล

นักพัฒนาสามารถ:

- หยุดและเปลี่ยนทิศทางโมเดลระหว่างทำงาน

- ปรับแก้ซ้ำอย่างรวดเร็วด้วยการตอบสนองเกือบทันที

- แก้ไขโค้ดเฉพาะจุดอย่างแม่นยำ

- หลีกเลี่ยงการรันเทสต์อัตโนมัติ เว้นแต่จะร้องขอ

โมเดลมีรูปแบบการทำงานที่เน้นความเบาและคล่องตัว แทนที่จะสร้างโซลูชันที่ซับซ้อนเกินจำเป็น Codex Spark จะเน้นการแก้ไขแบบตรงจุดและกระชับ ช่วยให้วงจรการเขียนโค้ดรวดเร็วและมีประสิทธิภาพ

ประสิทธิภาพ: เร็วและยังทรงพลัง

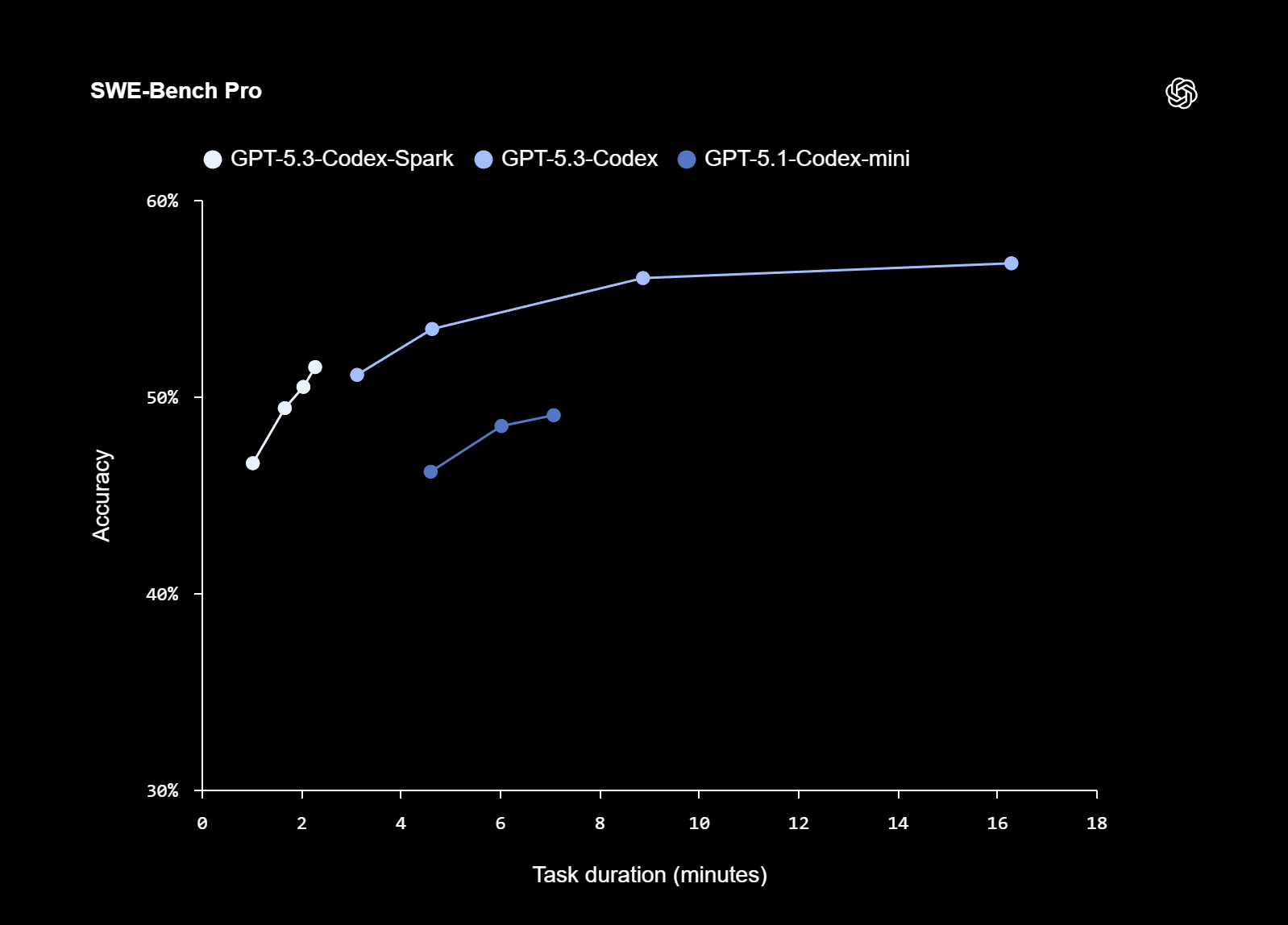

แม้จะมีขนาดเล็กกว่า GPT-5.3 Codex แต่ Codex Spark แสดงประสิทธิภาพที่แข็งแกร่งในเบนช์มาร์ก เช่น:

- SWE-Bench Pro

- Terminal-Bench 2.0

เบนช์มาร์กเหล่านี้ใช้ประเมินความสามารถด้านวิศวกรรมซอฟต์แวร์แบบ agentic โดย Spark แสดงความสามารถใกล้เคียงกัน แต่ใช้เวลาทำงานเพียงเศษเสี้ยว สะท้อนสมดุลระหว่างประสิทธิภาพและความเร็วได้อย่างชัดเจน

ปรับปรุงความหน่วงทั่วทั้งระบบ

ความเร็วไม่ได้มาจากตัวโมเดลเพียงอย่างเดียว แต่ครอบคลุมทั้งกระบวนการทำงานแบบ end-to-end

เพื่อรองรับ Codex Spark ทาง OpenAI ได้ปรับปรุงระบบอย่างมาก ได้แก่:

- ลด overhead ระหว่าง client/server ลง 80%

- ลด overhead ต่อโทเคนลง 30%

- ลดเวลาในการแสดงโทเคนแรก (time-to-first-token) ลง 50%

การอัปเกรดหลักประกอบด้วย:

- การเชื่อมต่อ WebSocket แบบถาวร

- การสตรีมผลลัพธ์ที่คล่องตัวขึ้น

- ปรับปรุง inference stack

- เริ่มต้นเซสชันได้รวดเร็วขึ้น

เส้นทางการให้บริการผ่าน WebSocket ถูกตั้งค่าเป็นค่าเริ่มต้นสำหรับ Spark และคาดว่าจะกลายเป็นมาตรฐานสำหรับโมเดลอื่น ๆ ในอนาคต

การปรับปรุงเหล่านี้ส่งผลดีต่อระบบนิเวศทั้งหมด ไม่ใช่เฉพาะ Codex Spark เท่านั้น

ขับเคลื่อนด้วย Cerebras: โครงสร้างพื้นฐานความหน่วงต่ำพิเศษ

หนึ่งในก้าวสำคัญของ Codex Spark คือความร่วมมือกับ Cerebras

โมเดลทำงานบน Cerebras Wafer Scale Engine 3 ซึ่งเป็นชิปเร่งความเร็ว AI ที่ออกแบบมาเพื่อการประมวลผลความเร็วสูงโดยเฉพาะ ทำให้เกิดชั้นการให้บริการที่เน้นความหน่วงต่ำเป็นหลัก และช่วยให้ Codex ตอบสนองได้รวดเร็วกว่าโครงสร้าง GPU แบบดั้งเดิมเพียงอย่างเดียว

แม้ว่า GPU ยังคงมีบทบาทสำคัญในการฝึกและประมวลผลขนาดใหญ่ที่คุ้มค่า แต่สำหรับเวิร์กโฟลว์ที่ต้องการรอบการตอบสนองรวดเร็วมาก ฮาร์ดแวร์ของ Cerebras จะช่วยย่นวงจรการตอบกลับได้อย่างชัดเจน

ผลลัพธ์คือโครงสร้างพื้นฐานแบบไฮบริด ที่ GPU และ Cerebras ทำงานเสริมกัน เพื่อมอบทั้งความสามารถในการขยายขนาดและความเร็ว

การเข้าถึงในช่วง Research Preview

ปัจจุบัน Codex Spark เปิดให้ใช้งานสำหรับ:

- ผู้ใช้ ChatGPT Pro

- แอป Codex เวอร์ชันล่าสุด

- Codex CLI

- ส่วนขยาย VS Code

นอกจากนี้ยังอยู่ระหว่างการทดสอบกับพาร์ตเนอร์ด้านการออกแบบ API บางราย เพื่อสำรวจแนวทางการผสานรวมเข้ากับผลิตภัณฑ์จริง

เนื่องจากใช้ฮาร์ดแวร์เฉพาะทางด้านความหน่วงต่ำ การเข้าถึงอาจมีข้อจำกัดหรือรอคิวในช่วงที่มีความต้องการสูง โดย rate limit จะแยกกำกับในช่วง research preview

มาตรฐานด้านความปลอดภัย

Codex Spark ผ่านการฝึกด้านความปลอดภัยเช่นเดียวกับโมเดลหลัก รวมถึงมาตรการด้านความปลอดภัยที่เกี่ยวข้องกับไซเบอร์

โมเดลผ่านการประเมินมาตรฐานการปรับใช้ ครอบคลุมความเสี่ยงด้านความปลอดภัยไซเบอร์และชีวภาพ และถูกประเมินว่าไม่ถึงเกณฑ์ความสามารถระดับสูงภายใต้กรอบ Preparedness Framework ของ OpenAI

สิ่งนี้ช่วยให้มั่นใจได้ว่า แม้โมเดลจะเร่งความเร็วเวิร์กโฟลว์การเขียนโค้ด แต่ยังคงสอดคล้องกับแนวทางการใช้ AI อย่างรับผิดชอบ

สู่ Codex แบบสองโหมด: เรียลไทม์และระยะยาว

Codex Spark คือก้าวแรกสู่ระบบ Codex ที่มีสองโหมดทำงานเสริมกัน ได้แก่:

- การให้เหตุผลและดำเนินงานระยะยาว

- การทำงานร่วมกันแบบเรียลไทม์

ในอนาคต นักพัฒนาอาจสามารถ:

- ปรับแก้แบบโต้ตอบในลูปสั้น ๆ

- มอบหมายงานย่อยที่ใช้เวลานานให้ agent ทำงานเบื้องหลัง

- กระจายงานขนานกันผ่านหลายโมเดล

- ผสานทั้งความครอบคลุม ความเร็ว และความอัตโนมัติ

นี่คือสัญญาณของยุคใหม่ในการทำงานร่วมกันระหว่างนักพัฒนาและ AI

ทำไม GPT-5.3 Codex Spark จึงสำคัญ

เมื่อโมเดล AI มีความสามารถมากขึ้น ความเร็วในการโต้ตอบกลายเป็นข้อจำกัดหลัก

การประมวลผลความเร็วสูงพิเศษเปลี่ยนวิธีคิด ทดลอง และสร้างของนักพัฒนา จากการรอผลลัพธ์เป็นรอบ ๆ สู่การทำงานร่วมกันอย่างลื่นไหล เปลี่ยนไอเดียให้กลายเป็นโค้ดได้แทบจะในทันที

GPT-5.3 Codex Spark ไม่ได้เป็นเพียงโมเดลที่เร็วขึ้น แต่กำลังนิยามจังหวะใหม่ของการเขียนโปรแกรมด้วย AI ทำให้ช่องว่างระหว่าง “ความตั้งใจ” และ “การลงมือทำ” แคบลงอย่างที่ไม่เคยเกิดขึ้นมาก่อน

และนี่เป็นเพียงจุดเริ่มต้นของตระกูลโมเดลความเร็วสูงพิเศษ ที่จะเปลี่ยนแปลงวิธีสร้างซอฟต์แวร์ในอนาคต

สนใจผลิตภัณฑ์และบริการของ Microsoft หรือไม่ ส่งข้อความถึงเราที่นี่

สำรวจเครื่องมือดิจิทัลของเรา

หากคุณสนใจในการนำระบบจัดการความรู้มาใช้ในองค์กรของคุณ ติดต่อ SeedKM เพื่อขอข้อมูลเพิ่มเติมเกี่ยวกับระบบจัดการความรู้ภายในองค์กร หรือสำรวจผลิตภัณฑ์อื่นๆ เช่น Jarviz สำหรับการบันทึกเวลาทำงานออนไลน์, OPTIMISTIC สำหรับการจัดการบุคลากร HRM-Payroll, Veracity สำหรับการเซ็นเอกสารดิจิทัล, และ CloudAccount สำหรับการบัญชีออนไลน์

อ่านบทความเพิ่มเติมเกี่ยวกับระบบจัดการความรู้และเครื่องมือการจัดการอื่นๆ ได้ที่ Fusionsol Blog, IP Phone Blog, Chat Framework Blog, และ OpenAI Blog.

New Gemini Tools For Educators: Empowering Teaching with AI

ถ้าอยากติดตามข่าวเทคโนโลยีและข่าว AI ที่กำลังเป็นกระแสทุกวัน ลองเข้าไปดูที่ เว็บไซต์นี้ มีอัปเดตใหม่ๆ ให้ตามทุกวันเลย!

Fusionsol Blog in Vietnamese

Related Articles

- Microsoft 365 คืออะไร?

- What is Azure AI Foundry Labs?

- Power BI Free Plan: A Deep Dive into Microsoft’s BI Solution

- Data Warehouse คืออะไร?

- Microsoft Fabric คืออะไร?

- GitHub Copilot คุ้มค่าหรือไม่?

- Claude Opus 4.6: Now available in Microsoft Foundry on Azure

- Ads in ChatGPT: Testing ads, Emphasizing its independence

Frequently Asked Questions (FAQ)

Microsoft Copilot คืออะไร?

Microsoft Copilot คือฟีเจอร์ผู้ช่วยอัจฉริยะที่ใช้ AI เพื่อช่วยในการทำงานภายในแอปของ Microsoft 365 เช่น Word, Excel, PowerPoint, Outlook และ Teams โดยทำหน้าที่ช่วยสรุป เขียน วิเคราะห์ และจัดการข้อมูล

Copilot ใช้งานได้กับแอปไหนบ้าง?

ปัจจุบัน Copilot รองรับ Microsoft Word, Excel, PowerPoint, Outlook, Teams, OneNote, และอื่น ๆ ในตระกูล Microsoft 365

ต้องเชื่อมต่ออินเทอร์เน็ตหรือไม่จึงจะใช้งาน Copilot ได้?

จำเป็นต้องเชื่อมต่ออินเทอร์เน็ต เนื่องจาก Copilot ทำงานร่วมกับโมเดล AI บนคลาวด์เพื่อให้ผลลัพธ์ที่แม่นยำและอัปเดตข้อมูลล่าสุด

สามารถใช้ Copilot ช่วยเขียนเอกสารหรืออีเมลได้อย่างไร?

ผู้ใช้สามารถพิมพ์คำสั่ง เช่น “สรุปรายงานในย่อหน้าเดียว” หรือ “เขียนอีเมลตอบลูกค้าอย่างเป็นทางการ” และ Copilot จะสร้างข้อความให้ตามคำสั่ง

Copilot ปลอดภัยต่อข้อมูลส่วนบุคคลหรือไม่?

ใช่ Copilot ได้รับการออกแบบโดยยึดหลักความปลอดภัยและการปกป้องความเป็นส่วนตัว โดยข้อมูลของผู้ใช้จะไม่ถูกใช้ในการฝึกโมเดล AI และมีระบบการควบคุมสิทธิ์การเข้าถึงข้อมูลอย่างเข้มงวด